中国の大手Eコマース企業AlibabaのAIチーム「Qwen」は、2024年11月28日、新しい推論特化型AIモデル「Qwen with Questions(QwQ)」のプレビュー版として、「QwQ-32B-Preview」をリリースしました。

このモデルは、325億ものパラメーターと最大32768トークンのコンテキスト処理能力を誇り、特に論理的推論や問題解決において高い性能を発揮します。また、回答を生成後に再確認し誤りを修正する仕組みを備えているため、数学やコーディングといった高度なタスクでも正確な回答が期待できる点が最大の特徴です。

こうした特徴から、OpenAI の推論モデル「o1」へのオープンソース競合モデルとして、QwQは大規模言語モデル(LLM)や大規模推論モデル(LRM)の進化を象徴する次世代モデルとして注目されています。

QwQとは何か?

QwQは「Qwen with Questions」の略で、質問に対する高度な推論能力を提供することを目的に開発されたAIモデルです。このモデルは、数学的な問題やコーディングのタスクなど、論理的思考を必要とする分野で特に優れた性能を発揮します。また、生成した回答を自己検証し、誤りを修正する「自己反省プロセス」を導入することで、回答の正確性を向上させています。

さらに、プレビュー版である「QwQ-32B-Preview」はApache 2.0ライセンスの下で公開されており、商用利用が可能です。Hugging Faceのプラットフォームで試すことができ、開発者や研究者が簡単にアクセスできる設計となっています。

最大の特徴:自己検証プロセスで精度を向上

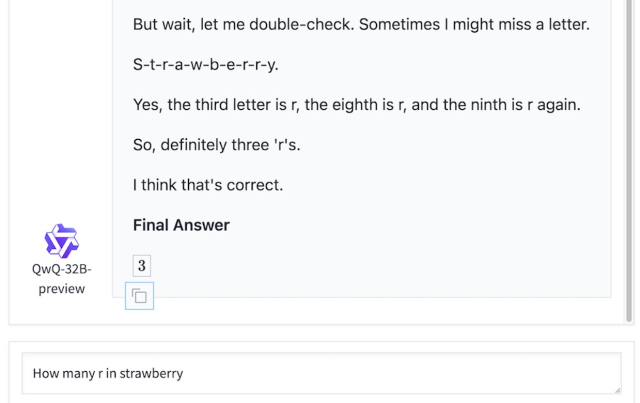

QwQの最大の特徴は、「自己検証(セルフリフレクション)機能」です。モデルは回答を生成する過程で、自らの思考プロセスを振り返り、誤りを検出・修正します。このプロセスにより、複雑なタスクでも精度の高い結果を提供することが可能です。

たとえば、以下のような数学やプログラミングの問題では、回答を生成後に再検証し、不適切な箇所を修正するため、最終的な結果の信頼性が大幅に向上します。

QwQ-32B-Previewの優れたベンチマーク性能

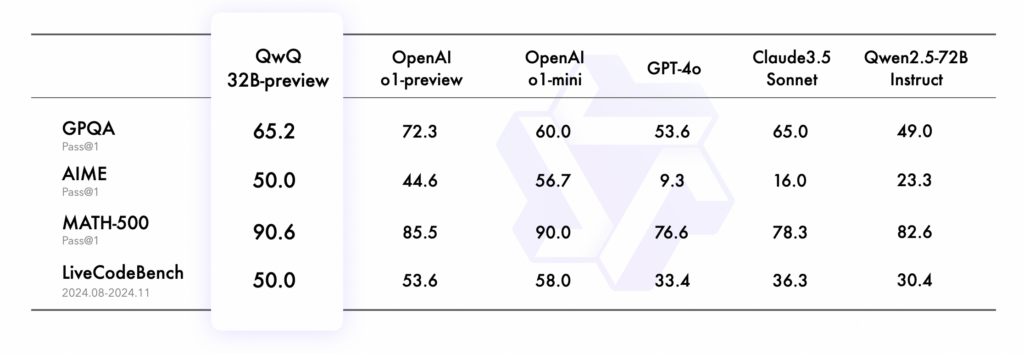

AlibabaのQwQ-32B-Previewは、いくつかの重要なベンチマークで他の先端モデルを上回る性能を示しています。

- 数学ベンチマーク(AIME・MATH-500)

- QwQ-32B-Previewは、数学的問題解決能力を評価するこれらのベンチマークで、OpenAIの「o1-preview」や他の競合モデルを凌駕しました。

- 科学的推論(GPQA)

- 科学分野の推論能力を測定するGPQAでも、o1-miniを上回る結果を記録しており、大学院レベルの科学的推論能力を示しました。

- コーディング(LiveCodeBench)

- コーディングタスクでは、一部の先端モデルには及ばないものの、Claude 3.5 SonnetやGPT-4oなどの多くの競合モデルを超えるパフォーマンスを発揮しました。

これらの実績により、QwQは論理的推論を要するタスクにおいて非常に強力なモデルであることが証明されています。

QwQの4つの課題

現在プレビュー段階であるQwQには、いくつかの課題も存在します。たとえば、言語混同や循環的な推論に陥る可能性が指摘されており、より精度を高めるための改良が必要です。

- 言語混合とコードスイッチング(Language Mixing and Code-Switching)

- モデルが異なる言語を混在させたり、突然切り替えたりすることがあり、回答の明瞭性に影響を与える場合があります

- 循環的な推論ループ(Recursive Reasoning Loops)

- 結論のない長い応答を生成する場合があり、効率性を損なう可能性があります

- 安全性と倫理的配慮(Safety and Ethical Considerations)

- モデルの信頼性と安全性を確保するためには、さらなる安全対策が必要であり、利用者は慎重に運用する必要があります

- 性能とベンチマークの限界(Performance and Benchmark Limitations)

- モデルは数学とコーディングに優れていますが、常識的な推論やニュアンスのある言語理解など、他の分野では改善の余地があります

QwQの将来展望

QwQの基本設計やオープンソース戦略は非常に革新的であり、さらなる開発が進めば、多くの分野で活用される可能性があります。

特に、これまでの大規模言語モデル(LLM)は、パラメーター数を増やすことで性能向上を図ってきました。しかし、モデルのサイズ拡大にはコストやデータ不足などの課題が伴います。その中で、推論過程を強化し、モデルが自らの回答を精査するLRM(大規模推論モデル)が注目されています。

QwQは、LRMの可能性を示すモデルとして、次世代AIの方向性を明確にしました。Alibabaは、QwQを通じてAI研究の新たな地平を切り開きつつあり、その影響は競合他社や研究機関に波及していくことでしょう。

まとめ

Alibabaが開発した「Qwen with Questions(QwQ」)は、推論に特化したAIモデルとして、高度なタスクへの適応能力と正確性を兼ね備えています。オープンソースかつ商用利用可能な点も大きな強みです。

このモデルは、AI分野における革新の一端を担う存在であり、今後さらに進化することで、より幅広い分野での利用が期待されています。その動向には引き続き注目が集まることでしょう。