近年、ChatGPTやGeminiといった大規模言語モデル(LLM)が急速に発展し、私たちの生活やビジネス環境を大きく変えています。高度なテキスト生成や自動翻訳、プログラミング支援など、多様な用途で活用されていますが、その一方で莫大な計算資源が必要となり、運用コストや消費電力の増大が喫緊の課題です。特に、クラウドサーバー上で動作するLLMは、リアルタイム処理の遅延やデータプライバシーの問題を抱えており、これらを解決する技術が求められています。

そこで注目されているのが、小規模言語モデル(SLM)です。SLMは、スマートフォンやPCなどの端末上で直接動作し、オフラインでも利用可能なコンパクトなAIです。特定用途に最適化されているため、軽量でありながら実用的な精度を確保できるのが大きな強みです。ただし、SLMはLLMほどの学習能力を持たないため、「いかにして小規模ながら高性能な言語モデルを構築するか」が大きな課題となっていました。

この課題を解決するために、2025年1月30日、日本のAI企業「Sakana AI」が新しい知識蒸留技術「TAID」を採用した日本語特化のSLM「TinySwallow-1.5B」を発表しました。このモデルは、わずか15億のパラメータでありながら、大規模AIに匹敵する日本語理解能力を発揮します。さらに、クラウドを介さずにスマートフォンやPC上でオフライン動作できるため、プライバシー保護や処理の高速化にも貢献するでしょう。

本記事では、TinySwallow-1.5Bの特徴や技術的な革新性、実際の活用シーンについてわかりやすく解説します。

TinySwallow-1.5Bとは?小型で高性能な日本語AIモデル

TinySwallow-1.5Bは、Sakana AIが開発した日本語特化型の小規模言語モデル(SLM:Small Language Model)です。このモデルは、大規模言語モデル(LLM)の知識を小規模なモデルに転移する新手法「TAID」を活用して開発されました。なお、TAIDによって作った小規模モデルを多くの人に使ってもらうため、英語のSLMである「TAID-LLM-1.5B」も開発されています。

TinySwallow-1.5Bの最大の特徴は、やはり小規模ながら高性能である点。わずか15億のパラメータしかなく、スマホで快適に動くほど軽量であるものの、日本語の小規模言語モデルとして最高性能を示しました。

また、従来のLLMと比べて、軽量かつ省エネルギーであるため、スマートフォンやPC上でオフラインでも動作可能です。たとえば、従来のAIチャットボットはクラウド経由で大規模サーバーを利用する必要がありましたが、TinySwallow-1.5Bはローカル環境で直接動作できるため、プライバシー面でもメリットがあります。

<TinySwallow-1.5Bの特徴>

- 高性能かつ軽量: 1.5B(15億)パラメータながら、大規模LLMに匹敵する日本語理解能力

- スマートフォンやPCで動作: APIを介さず、オフライン環境でも利用可能

- 知識蒸留の新手法「TAID」を採用: 効率的な知識転移で高い精度を実現

- オープンソース: モデルの詳細はHugging Faceで公開

TinySwallow-1.5Bの技術的革新「TAID」とは?

TinySwallow-1.5Bに活用されている革新的な技術「TAID(Temporally Adaptive Interpolated Distillation:時間適応型補間蒸留)」は、Sakana AIが開発した新しい「知識蒸留」の手法です。

知識蒸留とは:LLMの知識をSLMに効率的に転移させる技術

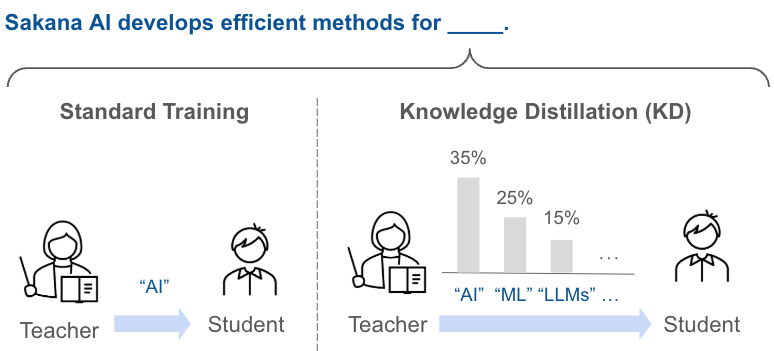

知識蒸留(ディスティレーション)とは、大規模な教師モデル(LLM)の知識を、小規模な生徒モデル(SLM)に効率的に転移する技術です。ゼロからSLMを学習するよりも、効率的かつ高性能なSLMを作ることができることで知られています。

知識蒸留の特徴は、単に「正解」を教えるだけでなく、教師モデルの「考え方」も生徒モデルへ教示できる点です。通常の機械学習では「正解データ」だけを学習しますが、知識蒸留では教師モデルの思考プロセスも含めて伝達することで、より高度な学習が可能になります。

たとえば、従来の学習が「問題の解答だけを暗記する」ようなものだとすると、知識蒸留は「問題の解き方まで理解する」イメージに近いです。

TAIDの仕組み:生徒モデルの学習速度に合わせて教師モデルを調整

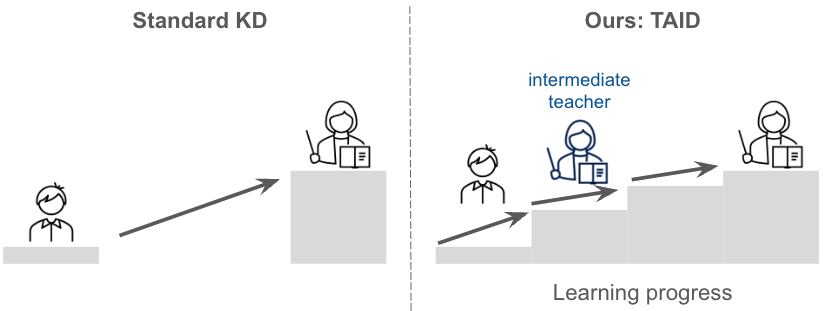

しかし、従来の知識蒸留では、教師モデルと生徒モデルの能力差が大きすぎると、学習がうまくいかないという課題がありました。これを解決するのが、今回Sakana AIが開発した新たな知識蒸留の手法「TAID(時間適応型補間蒸留)」です。

TAIDでは、生徒モデルの学習進度に合わせて、段階的に教師モデルの難易度を上げる仕組みを採用しています。これは、人間の学習過程に似ており、最適なレベルの教師から学ぶことで、より効果的に知識を吸収できます。

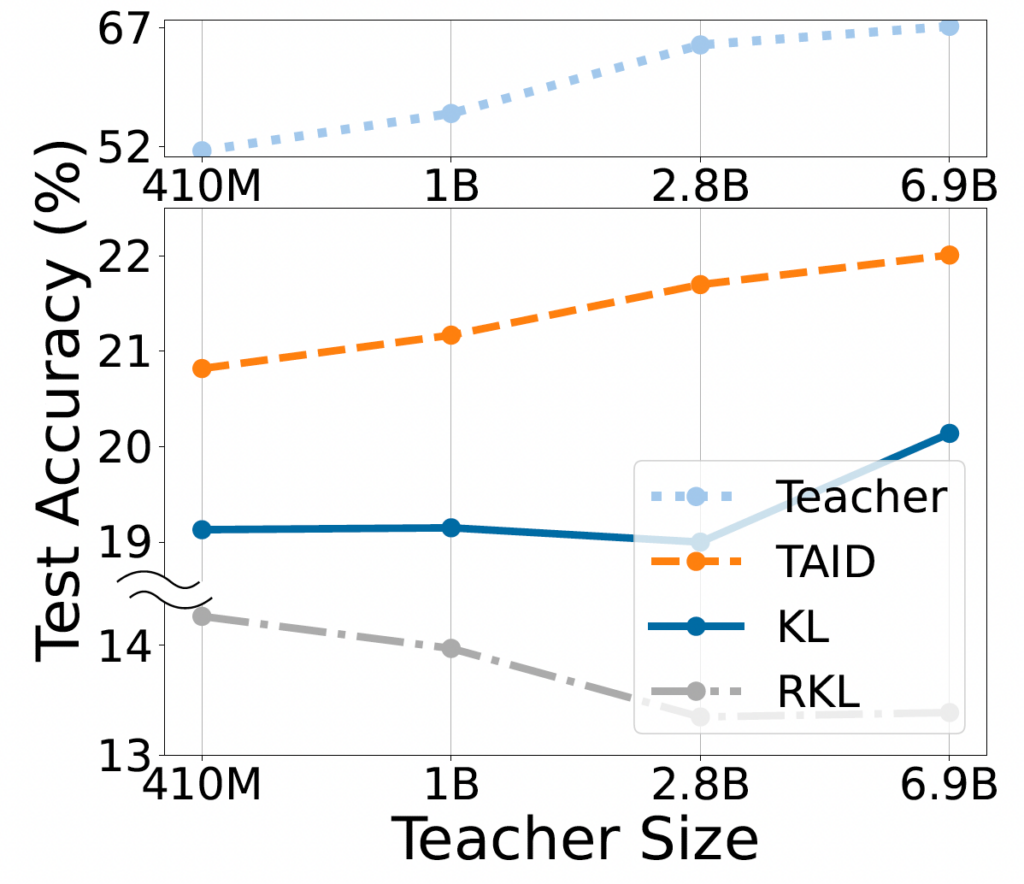

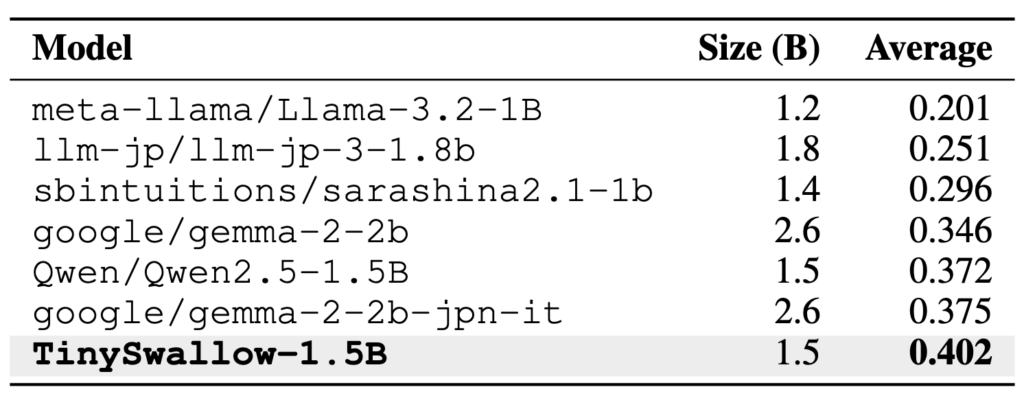

上図は、教師モデルの大きさ(横軸:Teacher Size)を変化させたときの、従来手法とTAIDによる知識蒸留を行った生徒モデルの性能(縦軸:Test Accuracy)です。従来手法(KLおよびRKL)では、教師モデルが大きくなると、むしろ性能が低下してしまうことが確認できます。

一方、TAIDは教師モデルの大きさに比例して、生徒モデルの性能は単調増加しています。これは、TAIDが教師と生徒の能力差を効果的に克服できていることを示しています。

TAIDの効果:同規模のSLMの中で最高性能を発揮

Sakana AIはTAIDの活用により、320億パラメータの大規模LLMから、15億パラメータのTinySwallow-1.5Bへの知識転移に成功しました。その結果、日本語ベンチマークテストでは、同規模帯のモデルの中で最高水準の精度を記録しています。

TinySwallow-1.5Bの活用シーン

TinySwallow-1.5Bは、さまざまな分野での応用が期待されています。

- 企業の業務支援

- 個人向けAIアシスタント

- ゲームやエンターテイメント

1. 企業の業務支援

- 社内文書の自動要約・翻訳: 重要な会議の議事録や報告書を自動で要約

- チャットボットの高度化: 社内問い合わせ対応やヘルプデスクの自動化

2. 個人向けAIアシスタント

- プライベートなメモ管理: 個人の思考整理やタスク管理

- オフライン環境でのAI活用: インターネットに接続せずにAIアシスタントを利用

3. ゲームやエンターテイメント

- 対話型AIキャラクターの開発: ゲーム内のNPCの会話を高度化

- 物語生成AI: クリエイター向けのストーリー作成支援

TinySwallow-1.5Bの利用方法

TinySwallow-1.5Bはオープンソースで提供されており、誰でも試すことができます。特に、ブラウザ上で動作するTinySwallow ChatUIを使えば、アプリのダウンロード不要で簡単に試すことが可能です。

また、完全オフラインで利用したい場合は、TinySwallow ChatUI Localをインストールすれば、インターネット接続なしでモデルを動かせます。Pythonを使ってローカル環境で実行できるため、機密情報を外部に送信せずにAIを活用することが可能です。

さらに、TinySwallow-1.5Bには2つのバージョンが存在します。

- TinySwallow-1.5B:日本語に特化したSLMで、幅広いタスクに対応可能なベースモデル

- TinySwallow-1.5B-Instruct:追加の指示学習を施したバージョンで、ユーザーの指示により的確に応答できる強化版

どちらのバージョンもHugging Face Hubで公開されており、用途に応じて選択できます。たとえば、一般的な日本語処理を試す場合はベース版を、指示に対する応答精度を向上させたい場合はInstruct版を利用するとよいでしょう。

Sakana AIの今後の展望

TinySwallow-1.5Bの開発を通じて、新しい知識蒸留手法「TAID」の有効性が証明されました。Sakana AIは今後、さらなる小規模モデルの開発や、TAIDの応用範囲拡大を進める予定です。

たとえば、現在は言語モデル中心ですが、今後は画像・音声認識分野にもTAIDを応用する可能性があります。これにより、より小型で高性能なAIが普及し、エネルギー消費を抑えながらも、優れた性能を発揮する次世代AIの実現が期待されます。

まとめ

- TinySwallow-1.5Bは、Sakana AIが開発した高性能な日本語小規模言語モデル

- 新手法「TAID」により、大規模モデル並みの知識を小型モデルに転移

- スマホやPCでオフライン動作可能な軽量モデル

- 企業の業務支援や個人向けAIアシスタント、ゲーム開発など幅広い用途に対応

- オープンソースで提供され、誰でも試すことが可能

今後もTinySwallow-1.5Bの活用が広がり、手軽に使える高性能AIが当たり前の時代が訪れるでしょう。